今だからこそ知りたいビッグデータ×AI(第4回)

※本記事は、未来技術推進協会ホームページにて2018年9月13日に掲載されたものです。

こんにちは。cygnusです。

前回の記事では、ビッグデータ活用の鍵となるパーソナルデータの活用とプライバシー保護の共存を目指す「プライバシー・バイ・デザイン」という思想をご紹介しました。

活用にあたりどのような思想や枠組みで「守り」をしていけば良いのかをお伝えしてきたので、今回からは実際にどのような分析・活用手法をとっていくかの「攻め」についてご紹介します。

目次

ビッグデータ分析の流れ

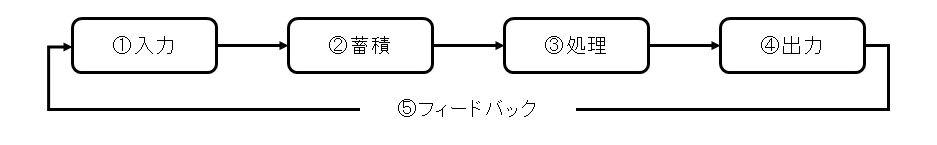

ビッグデータとはいえ、データを扱う流れは従来と大きくは変わりません。以下のような流れで扱っていきます。

<処理フロー>

(図1:ビッグデータ分析の処理フロー)

①入力:ビッグデータを蓄積する元となり、以前の記事でご紹介した3V(Volume、Variety、Velocity)を特徴とする様々なデータを取り込みます。

②蓄積:入力したデータを、処理しやすい形に整形し格納します。主要な整形として以下のようなものがあります。

- フォーマット化:データの表現にばらつきがなく一律処理できるように整形します。数字や文字の体系や桁数を揃えたり、同義語を統一した語に変換したり、画像や音声データを同じ表現形式に揃えたりします。

- パーティション化:日付や時刻で分類し、抽出・比較やマッチングがしやすいように整形します。月→日→時のように細分化して格納することでデータ抽出の速度を上げたり、同じ時刻のデータ同士や月や日だけが違うデータ同士の比較などを扱いやすいようにします。

- キー生成:異なる特性を持つデータ同士を紐付けやすいように整形します。異なる商品カテゴリで購入した結果を紐づけるためにWebクッキーやセッションの情報をキーにしたり、位置情報にラベルを付けてお店やスポットのデータを紐づけるキーにします。

③処理:蓄積したデータを、様々な分析手法を活用して分析することで知見を獲得します。機械学習や深層学習であればモデルの構築、顧客分析であれば購買や成約につながりやすい特性や条件の抽出、トレンド分析であれば現状と未来の予測結果の抽出などが考えられます。

④出力(可視化):獲得した知見を参照・再利用可能な形で出力します。グラフやレポート形式で出力したり、自システム・他システムで取り込みやすいような形式(例えばCSVやYAMLなど)で出力したり、webを通じて授受しやすい形式で出力したりします。

⑤入力へのフィードバック:このフィードバックはビッグデータ同士が連携して改善していく好循環を生むために非常に重要です。自身の出力結果を有効活用するだけでなく、システム間で連携することにより世界中の出力データに基づき自身の精度を上げていくことも可能になります。

過去に獲得した知見と比較して改善を図ったり、地球の裏側で得られた知見をすぐに反映して活用することができます。

<処理フローを踏まえたフォーカスポイント>

- 入力手法・項目の精査

- 分析基盤の構築・運用の必要性

- 出力結果のビジネス適用

データの収集や蓄積をするためのコンピューターリソースが潤沢になってきていることで、一旦集めて後からどうするか考えようという動きも多くなってきています。

ただ、ここであえて留意しておくことは、分析の目的や用途に合わせて適したデータ入力手法・項目を考えておく必要性です。

著者自身が体感してきたことを踏まえると、データの入力手法・取得項目を後から増やすにはコストがかかり、一定期間より前の過去データは削除されていることもあるなど、費用や物理的制約の中で取得できるデータが限られてしまうこともあります。

もちろん分析の中で新たな可能性を見出して対象が増えることもあるため一概にいうことはできませんが、少なくとも分析スコープを踏まえた精査をすることは大事なのではないでしょうか。

ビッグデータ分析による価値創出を加速させるためには、分析基盤の構築・運用が不可欠です。

メディアや企業の事例報告、研究論文では分析の手法や効果が取り上げられることが多いですが、そもそも上記の処理フローの入力からフィードバックまでを実現できる基盤があってこそのものであると理解することは重要です。

こちらについては、次の章でさらに詳細に記載します。

分析の結果として獲得した知見を、実際のビジネスにどのように活用するか、そしてその効果をどのように計測し次の施策に活かすかを検討し実行することが重要です。

年代や属性ごとの購買パターンが見えたことで実際にどのような実務で効果を上げるのか、地域と時間帯に応じた行動予測ができたことでどんな商品やサービスを開発していくのかなど、分析知見とビジネス適用を結び付けることで、価値を最大化していくことが重要です。

ビッグデータ分析基盤の構築・運用

情報科学や数理の知恵を活かして分析する分野を「データサイエンス」と呼び、このデータサイエンスが実現・運用できるようにする分野を「データエンジニアリング」と呼びます。

これらは互いに切っても切れない分野であり、 データサイエンスの知見に基づく分析手法や分析知見と同じくらい、データエンジニアリングに基づいて構築する分析基盤に重きを置いて考えることが重要です。

一般的にどのようなことを検討・考慮して構築する必要があるかを整理します。

- 入力データの収集方法、タイミング、費用対効果

- 蓄積するデータベース・プラットフォームの選定

- データの流れや特性の可視化

事業活動を実施・継続する中で生成されるデータを収集する場合、事業活動でのシステム稼動をひっ迫しないようなサイクル・タイミングを検討すること、そもそも参照用にデータをコピーしてもらうことで影響を切り離すことなどの考慮が必要となります。

調査会社や情報提供会社のデータ、国や公共機関などの一般公開データを収集する場合、それらの分析に対する効果性とかかる費用を見極めて収集対象や収集量を決めていく必要があります。

分析の規模によって許容できるデータ量や費用は異なりますが、それぞれに適した意思決定ができることが重要です。

蓄積するデータの量や特性、処理の頻度や参照するシステム・人の範囲に応じて、データベース製品やプラットフォームの選定が必要です。

大量のデータを分散させることで参照速度を重視する製品にするのか、バックアップやリカバリーの堅牢性よりも広くアクセスしやすいクラウドのプラットフォームにして使用に特化させるのかなど、用途に応じて選定していきます。

データ分散であればHadoopやSpark、クラウドプラットフォームはAWS、GCP、MS Azureのようなものが有名で、広く使われています。

現在は、分析や出力がWeb経由で広くできるようにクラウドのプラットフォームを使用する流れが増えてきています。

膨大なデータを扱うため、各種データがどこにどのような形で格納されているのか、それが用途に即したものかわかるような説明や要件が明示されているのか、現状どのように使われているのかが把握できる仕組みの整備が重要です。

既に分析・加工されたデータを二度手間で作成してしまうようなリスクを回避することから、データの格納形式や説明を明示し検索できるようにしておくことで共通知見として積み重ねる攻めの運用まで、可視化は貢献度が大きいと言えます。

後から整理しようとすると莫大な負荷がかかるので、最初からある程度可視化するための手法を検討・適用した上で、システムをスケールさせていくと運用に乗りやすいと考えられます。

総括

今回は、ビッグデータ分析に関する大まかな流れや重要なポイント、データエンジニアリングに基づく分析基盤の重要性をご紹介しました。

未来技術推進協会では、エクスポネンシャルテクノロジーと呼ばれる今後指数関数的な発展が見込まれる技術分野に注目しており、ビッグデータ分析もその一つです。

今回ご紹介したデータサイエンスについて学べる講座を始め、アイデアソンやLT会、懇親会などのイベントを企画しておりますので、ご興味のある方は是非ご参加ください。

次回は、クロス集計やロジスティック回帰といった分析手法をご紹介する予定です。

参考

EVENTS